인텔, "엔비디아 H100 너무 비싸다"…대항마 '가우디3' 공개

인텔 비전 2024 행사서 기업용 생성형 AI 시장 전략 밝혀

"비용 효율적 AI 반도체"…기업 선택권 확대에 초점 맞춰

국내 네이버와 협력…AI 생태계 구축 위한 공동 연구 추진

![[서울=뉴시스]인텔 비전 2024에서 팻 겔싱어 인텔 CEO가 인텔 가우디 3 가속기를 소개하고 있다. (사진=인텔 제공) photo@newsis.com *재판매 및 DB 금지](http://image.newsis.com/2024/04/11/NISI20240411_0001524073_web.jpg?rnd=20240411095646)

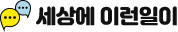

[서울=뉴시스]인텔 비전 2024에서 팻 겔싱어 인텔 CEO가 인텔 가우디 3 가속기를 소개하고 있다. (사진=인텔 제공) [email protected] *재판매 및 DB 금지

[서울=뉴시스]이인준 기자 = 미국 반도체 기업인 인텔이 엔비디아가 장악 중인 AI(인공지능) 반도체 시장에 본격적인 진출을 선언했다. 국내에서도 네이버와 협력을 맺고 공동 연구와 거대언어모델(LLM) 학습 인프라 구축도 추진하기로 했다.

인텔은 9일(현지 시각) 미국 애리조나에서 '인텔 비전 2024' 행사를 열고 AI 학습 및 추론용 반도체 '가우디 3(Intel Gaudi 3)'를 발표했다.

'인텔 비전'은 회사의 비즈니스 및 기술 경영진 리더가 고객과 파트너를 대상으로 개최하는 연례행사로, AI 최신 업계 트렌드와 기술 미래 등에 대해 논의하는 자리다. 지난해 12월 뉴욕에서 개최한 신제품 출시 행사에서 시제품을 선보인 지 4개월 만이다.

인텔은 이날 공개한 '가우디3'가 AI 반도체 시장을 사실상 독점하고 있는 엔비디아의 GPU(그래픽처리장치)를 대체할 것이라고 기대했다.

인텔에 따르면 가우디3는 엔비디아의 주력 AI 반도체인 H100 대비 학습 시간을 50% 단축할 수 있고, 추론 처리량도 50% 빠르다. 전력 효율도 40% 향상됐다

특히 가성비(가격 대비 성능 비율)면에서 유리할 전망이다. 현재 엔비디아 H100은 수급난으로 웃돈이 붙어, 제품 한 개당 최대 4만달러(5500만원)에 거래되는 것으로 알려졌다. 반면 인텔 가우디3는 이보다 훨씬 낮은 가격이라는 후문이다.

인텔은 "가우디 3 가속기는 학습 및 추론을 위한 여러 비용 효율적인 클라우드 거대언어모델(LLM) 인프라를 지원해 기업들에게 가격 대비 성능의 이점과 선택권을 제공할 예정"이라고 강조했다.

인텔은 이번 행사에서 기업용 AI 시장을 적극적으로 공략하겠다는 뜻을 밝혔다.

가우디3는 올해 2분기부터 델(Dell), HPE, 레노버(Lenovo), 슈퍼마이크로(Supermicro) 등 시스템에 탑재될 예정이다.

인텔에 따르면 지난해 기준 생성형 AI 솔루션을 실제 업무에 도입하는 기업은 10%에 불과하다. 비용도 문제지만 개방성과 선택권을 제한하고 개인정보 유출 등 보안 문제로 인프라 구축이 난관으로 지목되고 있다.

![[서울=뉴시스]인텔 가우디 3 가속기(사진=인텔 제공) photo@newsis.com *재판매 및 DB 금지](http://image.newsis.com/2024/04/11/NISI20240411_0001524086_web.jpg?rnd=20240411100235)

[서울=뉴시스]인텔 가우디 3 가속기(사진=인텔 제공) [email protected] *재판매 및 DB 금지

국내서도 AI 생태계 개척 나서…네이버와 협력

인텔은 이날 서울 여의도 FKI회관 루비홀에서 '인텔 비전(Intel Vision) 미디어 간담회'를 열고 네이버와 생성형 AI 모델과 애플리케이션을 개발하고 관리하기 위한 공동 연구개발 투자를 진행한다고 밝혔다. 여기에는 스타트업과 학계 등도 참여한다. 네이버 관계자는 "인텔과 네이버가 함께 투자해서 국내 AI 생태계에서 폭넓은 가상의 연구 프로그램이 이뤄질 것"이라 설명했다.

네이버는 또 인텔 AI 가속기를 활용한 거대언어모델(LLM) 구축도 추진한다.

네이버에 따르면 앞으로 가우디 3의 전작인 '가우디 2'를 활용한 테스트가 본격적으로 시작된다. 네이버는 현재 자체 개발한 '하이퍼 클로바X'를 기반으로 생성형 AI 서비스를 구축하는 동시에 대규모 데이터센터를 운영하고 있다. 네이버는 인텔 AI 가속기의 테스트 결과를 바탕으로 LLM 학습 인프라 구축에 적용할 계획이다.

이동수 네이버클라우드 하이퍼스케일 AI 담당이사는 이번 협력과 관련해 "인텔은 현재 바로 사용할 수 있는 여러가지 하드웨어가 준비돼 있어 가능성을 확인해볼 것"이며 "전력 대비 성능이 좋아졌다는 부분과 인텔의 데이터센터의 폭넓은 운영 경험이 차별적 협력 포인트가 될 것"이라고 밝혔다.

또 그는 현재 개발이 진행 중인 추론 칩 '마하-1' 등과 관련한 삼성전자와의 협력 방향에 대해서는 "삼성과 인텔 모두 저희의 소중한 파트너"며 "삼성과의 협업은 별도의 얘기"라고 덧붙였다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지