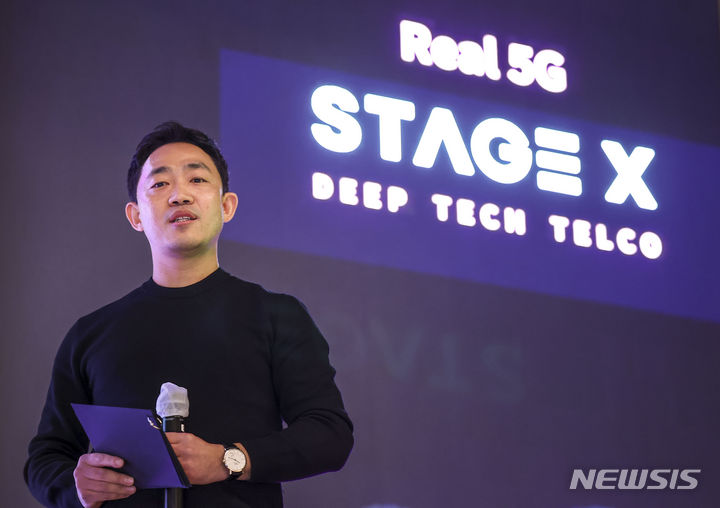

"GPT가 더 인간적인가?"…구글 vs 오픈AI의 새 AI 뭐가 다를까

구글 I/O 행사서 제미나이 1.5 시리즈와 AI 신기능 선봬

카메라 앱에 제미나이 접목…주변 환경 인식·기억 후 답변까지

오픈AI는 GPT-4o 발표…"옛날 얘기 해줄게" 감정 담은 대화도 가능

![[마운틴뷰=AP/뉴시스]순다르 피차이 구글 최고경영자(CEO)가 14일(현지시각) 미국 캘리포니아 마운틴뷰에서 진행된 연례 개발자 회의 '구글 I/O'에서 연설하고 있다. 2024.5.14.](http://image.newsis.com/2024/05/15/NISI20240515_0001096281_web.jpg?rnd=20240515045526)

[마운틴뷰=AP/뉴시스]순다르 피차이 구글 최고경영자(CEO)가 14일(현지시각) 미국 캘리포니아 마운틴뷰에서 진행된 연례 개발자 회의 '구글 I/O'에서 연설하고 있다. 2024.5.14.

구글의 제미나이 신기능 공개에 앞서 경쟁사인 오픈AI도 보고 듣고 말하는 'GPT-4o'를 발표하면서 AI 분야 최고 선두주자인 두 업체의 기술들에 관심이 쏠리고 있다.

구글, 구글 I/O 행사서 제미나이 1.5 시리즈 공개하고 AI 신기능도 꺼내

특히 구글은 제미나이 1.5 시리즈가 100만개의 토큰(개발자용 200만개)을 한번에 지원하는 '문맥 창(Context Window)'을 갖추고 있다고 강조했다.

AI 모델이 명령을 처리할 때는 답변을 생성하는 동안 확인할 수 있는 정보의 양이 제한되는데, 이때 검토·확인할 수 있는 텍스트 범위의 크기를 문맥 창이라고 지칭한다.

일반적으로 문맥 창의 크기가 클수록 AI의 정보 처리 능력 등 성능이 올라가게 된다. 구글에 따르면 제미나이 1.5는 1500페이지에 달하는 여러 개의 대규모 문서를 한번에 이해하거나, 100개의 이메일을 한번에 요약할 수 있는 수준의 문맥 창을 갖췄다.

구글은 이번 구글 I/O 행사에서 지메일, 카메라, 구글 검색 등 다양한 자사 서비스와 제미나이를 결합하겠다고 밝혔다. 대부분은 문서 요약 및 내용 분석, 텍스트 해석 능력 강화 등 기존의 생성형 AI의 기능을 강화하는 수준이었지만 가장 눈에 띄는 것은 제미나이와 카메라 앱을 결합한 것이다. 흔히 SF(공상과학) 영화 등에 나오는 것처럼 주변 상황을 인식하고 대화할 수 있는 기능이 담긴 것이다.

구글이 공개한 기술 데모를 살펴보면 제미나이는 사용자가 과거에 보여준 모습을 기억해낸다. 구글은 카메라에 다양한 물건들이 놓인 여러 개의 책상을 보여주고, 그와 관련된 무작위 질문들을 수차례 늘어놨다. 이후 제미나이에게 "내 안경을 마지막에서 어디에서 보았나"고 물으면 "네 안경은 O번째 테이블에 빨간 사과 옆에 있었다"라고 답해주는 식이다.

또 구글은 이번 구글 I/O 행사 하루 전에도 소셜미디어(SNS)를 통해 카메라에 담긴 제미나이 기능을 선보이기도 했다. 구글 I/O 행사가 준비 중인 모습을 카메라에 담은 뒤 "무슨 일이 벌어지고 있는 것 같아?"라고 묻자 제미나이가 "사람들이 큰 행사, 아마도 회의나 프레젠테이션을 준비하는 것 같다"고 답했다.

아직 구글이 해당 기능의 상용화 시점 등을 명확하게 밝히진 않았으나 성능을 보다 다듬은 후 출시된다면 영화 아이언맨 속 '자비스', 영화 그녀(Her) 속 '사만다' 등과 같은 수준의 AI로 진화할 것으로 기대된다.

"사람처럼 빠르고 감정 담은 대화"…GPT-4o 앞서 선보인 오픈AI

![[뉴욕=AP/뉴시스]오픈AI의 챗GPT 앱이 아이폰에 표시된 모습. 2024.05.02.](http://image.newsis.com/2024/04/19/NISI20240419_0001029195_web.jpg?rnd=20240502105150)

[뉴욕=AP/뉴시스]오픈AI의 챗GPT 앱이 아이폰에 표시된 모습. 2024.05.02.

GPT-4o는 챗봇 형태로 주로 텍스트를 통해 대화하던 챗GPT 모델과 달리 이용자와 실시간 음성 대화를 중심으로 한다. 기존 모델에 담긴 텍스트 대화는 물론, 시청각 추론 및 음성 답변까지도 가능하다.

오픈AI가 행사에서 진행한 시연을 살펴보면 GPT-4o과의 대화는 실제 사람과의 대화와 구분하기 어려울 정도로 자연스럽게 이어졌다. 사람의 대화 응답 시간과 비슷한 평균 320밀리초(0.32초) 내에 질문에 대한 답변이 가능하다는 게 오픈AI의 설명이다.

응답시간이 사람처럼 빠를 뿐만 아니라 '감정'을 담은 듯한 대화도 가능했다. 행사 시연자가 GPT-4o에게 "잠을 잘 못자는 친구를 위해 이야기를 들려달라"고 요구하자 GPT-4o는 마치 할머니가 어린 손주들에게 들려주듯 '옛날 옛적에'로 시작되는 이야기를 시작했다. 시연자가 더 감정적으로 이야기를 해달라고 하자 마치 성우나 배우처럼 더 극적이고 감정을 섞은 목소리로 대화를 이어나가기도 했다.

이외에도 "내가 조금 긴장이 되는데 진정하려면 어떻게 해야 할까"라고 묻자 친구가 격려하듯이 "숨을 깊이 들이마셔봐"라는 답변이 돌아오기도 했다.

물론 AI의 정체성에 맞게 감정이 섞인 대화만 가능한 것이 아니라 수학 문제를 풀거나 각기 다른 언어 간 통역을 해주는 기능 등도 포함됐다. 오픈AI는 GPT-4o가 지난해 11월 선보인 최신 모델인 GPT-4 터보보다 속도는 2배 더 빠르면서 비용은 절반 수준이라고 강조했다.

아직 구글과 오픈AI가 선보인 '보고 듣고 말하는' AI들은 이제 막 초기 단계의 모델이다. 아직 추가 학습 등을 통해 더 사람과 같아질 가능성이 존재하는 셈이다. 하지만 현재까지 공식 공개된 모습들을 살펴보면 오픈AI의 GPT-4o가 더 감정적인, 즉 더 사람에 가깝게 구현된 것으로 보인다.

제미나이 1.5가 카메라에 담긴 모습을 본 뒤 질문을 듣고 답변하기는 했으나 GPT-4o처럼 다양한 감정을 보여주는 모습을 보여주진 않았기 때문이다. AI가 주변 환경이나 문제를 살펴본 뒤 객관적인 추론을 내놓는 능력에 대해서는 우열을 가리기 어려운 것으로 보인다. 양사의 AI 모두 시연에서 크게 결함을 보이지 않고 정확한 결과를 내놓았기 때문이다.

10여년 전 개봉했던 SF 영화에서는 AI와 인간적인 대화와 감정 교류를 나누고 심지어 사랑에 빠지기까지 했던 주인공이 등장한 바 있다. 글로벌 빅테크들이 텍스트에 그치지 않고 시각, 청각까지 활용하는 AI를 선보이기 시작한 만큼 올해 진정한 AI 특이점이 찾아오게 될 지 주목된다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지