AI 수요 폭증 …"삼성·SK하닉 HBM 출하 58% 증가"

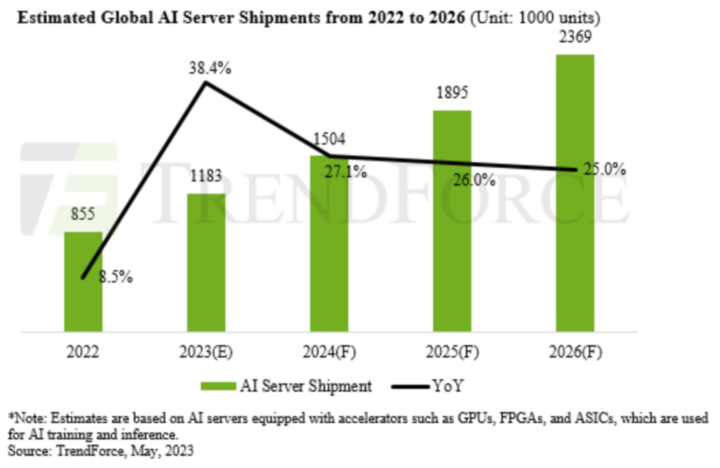

트렌드포스, 올 AI 서버 출하량 전년비 40%↑ 전망

"AI 서버 비중 현 9%에서 2026년 15% 증가할 듯"

HBM 시장의 90%는 韓 메모리 장악…수혜 기대

[서울=뉴시스]이인준 기자 = 올해 인공지능(AI) 서버 출하량이 작년보다 38.4% 늘면서, 차세대 메모리 반도체 D램인 고대역폭 메모리(HBM) 수요가 이전보다 58% 급증할 것이라는 관측이 제기됐다.

31일 시장조사업체 트렌드포스는 "올해 AI 서버 출하량이 급격히 늘어 세계 시장에서 120만대가 출하될 것"이라며 이렇게 전망했다.

트렌드포스는 최근 AI 산업이 커지면서 올해 전체 서버 출하량에서 AI 서버가 9% 비중을 차지할 것으로 봤다.

앞서 트렌드포스는 AI 서버 출하량의 5년(2022~2026년) 연평균 증가율(CAGR)을 10.8%로 전망했으나, 이번에는 22%로 상향 조정했다. 이에 AI 서버가 전체에서 차지하는 비중은 오는 2026년 15%까지 커질 전망이다.

AI 서버 시장의 급성장세는 고성능, 고용량 메모리 제품 수요 증가로 이어질 것으로 기대된다.

트렌드포스는 AI 연산에 필요한 고성능 GPU(그래픽처리장치) 수요가 급증하면서, 여기에 탑재되는 HBM 수요 역시 58% 증가할 것으로 봤다.

HBM은 D램 종류 중 하나로, 여러 개 D램을 수직으로 쌓아 일반 D램보다 데이터 전송 속도를 높인 제품이다. 트렌드포스는 내년에도 HBM의 수요가 추가로 30% 증가할 것으로 예측했다.

트렌드포스에 따르면 지난해 글로벌 HBM 시장에서 SK하이닉스가 시장점유율 50%로 1위를 달리는 가운데, 삼성전자와 마이크론이 각각 40%, 10%를 차지한 것으로 나타났다.

아직 시장 수요가 많지 않지만, 글로벌 빅테크 기업들은 급격하게 늘어나는 데이터를 빠르게 처리하기 위해 기존 D램 대비 성능을 현격히 높인 HBM을 채택하는 추세다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지