구글 이어 아마존, 내년엔 MS…HBM 큰 장 섰다

빅테크 자체 칩 개발 나서자 HBM 주문 '물 밀듯'

AI칩 용량 확대 가속화에 없어서 못 팔 지경

삼성·마이크론 추격전에…SK, 美HBM 조직 강화

![[AP/뉴시스] 지난 2012년 9월 6일(현지 시간) 찍힌 아마존 로고. 2025.11.25.](https://img1.newsis.com/2025/10/22/NISI20251022_0000733546_web.jpg?rnd=20251125054259)

[AP/뉴시스] 지난 2012년 9월 6일(현지 시간) 찍힌 아마존 로고. 2025.11.25.

빅테크들의 자체 AI 칩 개발은 메모리 업계에 있어 새로운 먹거리 시장이 열리는 것과 마찬가지다. 삼성전자, SK하이닉스의 HBM 수주 경쟁도 한층 더 달아오르고 있다.

5일 관련 업계에 따르면 HBM은 그동안 엔비디아의 AI 반도체인 그래픽처리장치(GPU)의 전유물처럼 여겨졌으나 최근엔 상황이 달라지고 있다.

아마존이 최근 공개한 최신 AI 칩 '트레이니엄3(Trainium 3)'는 칩 하나당 HBM3E(5세대 HBM) 4개씩 총 144GB(기가바이트) 용량의 메모리가 탑재된다.

이는 전작인 '트레이니엄2'(96GB) 대비 50%가량 증가한 것이다. 더 풍부하고, 빠른 답변을 위해 데이터 용량이 중요해진 탓이다.

최근 구글 생성형 AI '제미나이 3.0'의 성공적 출시도 HBM 시장의 판도 변화를 일으키고 있다. 이 추론 AI를 만드는데는 구글의 자체 칩 7세대 텐서처리장치(TPU) '아이언우드'가 사용됐는데, 이 칩 역시 전작 대비 32GB에서 192GB로 6배 증가했다.

아마존이 내년에 출시하는 차세대 트레니엄은 메모리 성능이 한층 더 강화된다. 마이크로소프트도 내년 말 차세대 '마이아200'(Maia200) 신제품을 출시할 예정인데, HBM 탑재 용량이 기존 36GB에서 288GB 큰폭으로 증가할 것으로 예상된다.

반면 엔비디아 GPU의 수요도 꾸준하다.

엔비디아는 최근 챗GPT 개발사 오픈AI와 추진 중인 1000억달러(147조원) 규모의 AI 인프라 투자 계약이 아직 성사되지 않았다고 밝혔다.

이는 젠슨 황 엔비디아 최고경영자(CEO)가 내년까지 블랙웰, 루빈 등 AI 가속기의 수주잔고로 언급한 5000억달러에서 추가 수요가 있을 수 있다는 점을 시사한다.

업계에선 내년 엔비디아와 빅테크 자체 칩의 사용 비중이 6대 4 수준일 것으로 짐작한다.

이에 메모리 업계의 HBM 고객 수주 경쟁은 한층 더 치열해질 전망이다.

SK하이닉스는 그동안 엔비디아 외에도 구글, 아마존 등 주문형 반도체용 HBM 시장을 선점해왔으나, 최근엔 삼성전자와 마이크론 등의 추격을 받고 있다.

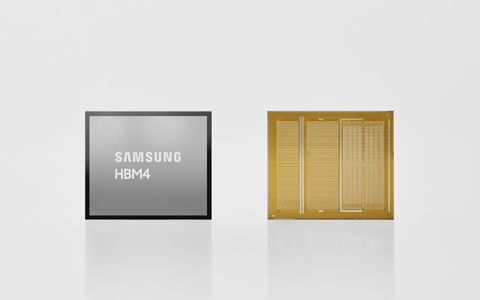

우선 삼성전자의 행보가 주목받는다. 삼성전자는 AMD, 구글·브로드컴과 HBM 사업 협력을 진행 중이며 최근 구글과 차세대 HBM4(6세대) 납품 계약을 체결한 것으로 알려졌다. 또 HBM4가 내부 기준을 충족해, 양산 채비에 들어간 것으로 전해졌다. 마이크론도 최근 HBM 생산에 집중하기 위해 소비자용 제품 출시 중단을 결정했다.

SK하이닉스는 HBM 1등 기술 리더십을 이어나가기 위한 조직 개편을 최근 단행했다. 미주 지역에 HBM 전담 기술 조직을 신설해 주요 HBM 고객들에 대한 신속한 기술 지원에 나서는 것이 주 내용이다.

또 앞으로 열릴 커스텀(Custom·맞춤형) HBM 시장 확대에 적기 대응한다. 이를 위한 HBM 패키징 수율, 품질 전담 조직도 별도 구축해 개발부터 양산, 품질 전 과정을 아우르는 HBM 특화 조직 체계를 구축한 상황이다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지