아마존, 기존 대비 4.4배 성능 높인 차세대 AI 칩 공개…GPU 대항마 될까

[AWS 리인벤트] 맷 가먼 CEO 기조연설

전작보다 4.4배 강력해진 AI 반도체 '트레이니움3' 출시…트레이니움4도 개발 착수

인프라부터 애플리케이션까지 '에이전틱 AI' 공격적 대비

기업 내부에 직접 구현해주는 AI 로컬 존 'AWS AI 팩토리즈' 첫 선

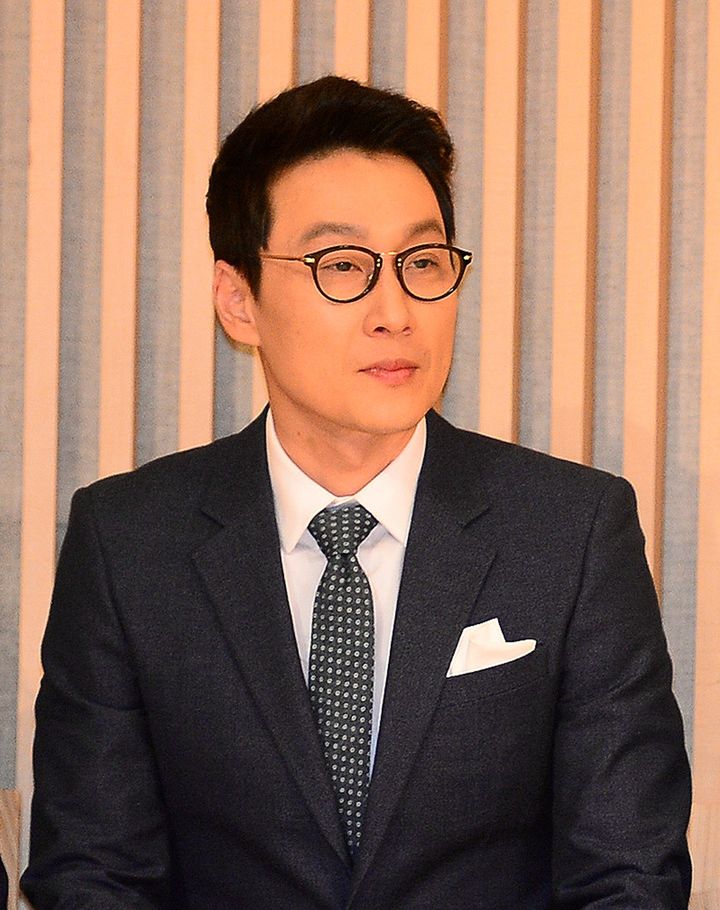

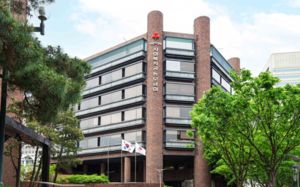

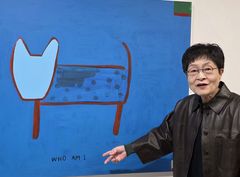

맷 가먼 아마존웹서비스(AWS) 최고경영자(CEO)가 미국 라스베이거스에서 열린 자사 연례 최대 행사 리인벤트에서 기조연설 하고 있다(사진=AWS코리아 제공) *재판매 및 DB 금지

[라스베이거스(미국)=뉴시스]송혜리 기자 = "인공지능(AI) 에이전트는 AI 발전의 궤도에서 중요한 변곡점을 도달했습니다."

맷 가먼 아마존웹서비스(AWS) 최고경영자(CEO)는 미국 라스베이거스에서 열린 자사 연례 최대 행사 리인벤트 연단에 올라 이같이 역설했다. AWS 리인벤트는 회사가 매년 미국 현지에서 여는 대규모 기술 행사로 전 세계 클라우드 전문가와 기업들이 모여 최신 기술, 서비스, AI 전략과 클라우드 혁신 사례를 발표하고 공유하는 글로벌 콘퍼런스다. 올해 행사에는 전세계 6만명이 참여했다.

"오늘 소개할 것이 정말 많다"며 셔츠 소매를 걷어붙인 가먼 CEO는 현지시각 2일 기조연설을 통해 AI 혁신을 가속할 AWS의 전방위적 신제품 전략을 공개했다. 그는 트레이니움3 기반으로 전작 대비 최대 4.4배 향상된 성능을 제공하는 '트레이니움3 울트라서버'부터, 기업 내부에 전용 AI 환경을 구축하는 'AI 팩토리즈', 아마존 베드록 모델 업데이트에 이르기까지 AI 전 영역을 아우르는 신제품을 한 번에 쏟아냈다.

가먼 CEO는 "우리는 에이전트가 의료 혁신을 가속하고 고객 서비스를 개선하며 급여 처리를 더욱 효율적으로 만드는 것을 보고 있다"면서 "그리고 일부 사례에서는 AI 에이전트가 사람의 업무 효율과 영향력을 10배 이상 확장하기 시작했다"고 말했다. 이어 "이제 기업들도 모든 비즈니스 프로세스를 근본부터 다시 설계할 필요가 있다"면서 "AWS는 여러분이 다음 것을 발명할 수 있도록, 스택의 모든 계층에서 혁신을 계속해왔다"고 강조했다.

기존 성능 대비 4.4배 향상…'트레이니움3 울트라서버' 공식 출시

트레이니움3는 AWS가 설계한 첫 3나노미터(nm) AI 칩으로, 대규모 AI 모델 학습과 다수 사용자 동시 실시간 추론 서비스를 보다 빠르고 효율적으로 처리할 수 있도록 고성능 AI 인프라 환경을 제공한다.

이를 탑재한 '트레이니움3 울트라서버'는 최대 144개의 트레이니움3 칩으로 확장 가능하며, 362FP8 페타플롭스(PFLOPs)의 성능을 구현한다. 전작 '트레이니움2 울트라서버' 대비 최대 4.4배 높은 컴퓨팅 성능, 4배 높은 에너지 효율, 약 4배 더 큰 메모리 대역폭을 제공하는 수준이다. 게다가 4배 낮은 지연 시간을 구현해 모델 훈련 시간을 몇 개월에서 몇 주로 단축하고 더 많은 사용자의 추론 요청을 동시에 처리하며, 출시 기간과 운영 비용을 모두 줄여준다.

이를 통해 기존에는 기술적·비용적 한계로 불가능했던 초거대 AI 모델 운영이 현실적인 시간과 비용 안에서 가능해졌다는 게 AWS 측 설명이다.

특히, AWS는 이미 차세대 트레이니움4 개발에도 착수했다고 공개했다. 이는 FP4 연산 성능 6배 증가, FP8 성능 3배 향상, 메모리 대역폭 4배 확장을 목표로 하고 있으며, 엔비디아 'NV링크 퓨전' 연동 지원을 통해 GPU·트레이니움 혼합 AI 인프라 구성도 제공할 계획이다.

기존 데이터센터를 고성능 AI 환경으로 전환하는 'AI 팩토리즈' 공개

이와 함께 이날 AWS는 고객의 기존 데이터센터 안에 전용 AI 인프라를 구축해주는 'AI 팩토리즈' 서비스를 발표해 눈길을 끌었다.

고객은 기존 데이터센터 공간·전력·네트워크를 그대로 활용하고 AWS가 배포·운영 복잡성을 책임지는 형태로, 엔비디아의 최신 AI 컴퓨팅 기술(GPU), AWS 트레이니움 칩, 고성능 네트워크, 스토리지 및 데이터베이스, 보안 시스템에 더해 '아마존 베드록'과 '아마존 세이지메이커'와 같은 AI 서비스까지 하나의 통합 환경으로 제공된다.

뿐만 아니라 AI 팩토리즈는 정부 기관이 요구하는 최고 수준의 보안 기준에 따라 설계돼, 비공개(Unclassified)부터 최상위 기밀(Top Secret) 등급까지 모든 민감 데이터를 처리할 수 있도록 지원한다.

이는 일종의 '프라이빗 AWS 로컬 존'처럼 작동해, 낮은 지연 시간, 보안 요건 충족, 데이터 주권 유지 등 규제 산업 요구사항을 준수한다. 이에 따라 AWS는 AI 팩토리즈가 데이터 주권 및 규제 준수 요구가 높은 정부 혹은 금융 등에서도 빠른 AI 도입을 할 수 있도록 돕는다고 강조했다.

'아마존 베드록', 사상 최대 규모 모델 업데이트 단행

아마존 베드락은 다양한 AI 모델을 하나의 플랫폼에서 손쉽게 선택·비교·활용할 수 있도록 지원하는 서비스로, 기업들이 빠르게 최신 AI 기술을 도입할 수 있도록 돕는다.일종의 'AI 백화점'이다.

먼저 AWS는 이날 아마존 베드락을 통해 미스트랄AI 의 두 가지 신규 모델을 최초로 공개했다.

이번에 공개된 미스트랄 라지 3(Mistral Large 3)는 긴 글의 흐름을 이해하고 텍스트와 이미지처럼 다양한 정보를 처리할 수 있는 능력을 갖춘 모델로, 사용자의 지시를 정확하게 수행하는 데 강점을 지닌 미스트랄AI의 가장 고급형 오픈 웨이트 모델이다. 미니스트랄 3(Ministral 3)은 크기는 작지만 범용성과 멀티모달 역량을 겸비해 소형 AI 모델 기준을 새롭게 정의하는 모델 시리즈로, 다양한 사용 사례에 유연하게 적용할 수 있는 것이 특징이다.

AWS는 자체 거대언어모델(LLM)인 노바Nova)2 모델 패밀리의 출시도 발표했다. 노바 2는 추론(reasoning), 멀티모달 처리, 대화형 AI 전반에서 업계 최고 수준의 가격 대비 성능을 제공하는 모델로 평가된다.

이와 함께 AWS는 기업이 대규모 환경에서도 안전하게 AI 에이전트를 구축·배포할 수 있도록 지원하는 플랫폼인 '아마존 베드록 에이전트코어'의 새로운 기능들도 소개했다.

새롭게 추가된 '폴리시 인 에이전트코어(Policy in AgentCore)' 기능은 에이전트가 도구를 사용해 수행 가능한 작업의 범위를 설정할 수 있도록 지원하며, '에이전트코어 이밸류에이션(AgentCore Evaluations)' 기능은 통해 에이전트가 실제 환경에서 어떻게 성능과 품질을 발휘할지 이해하도록 돕는다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지