“젊은 층 인공지능(AI) 지나친 의존, 비판적 사고 능력 손상”-英 학술지

연구팀, 비판능력 낮아지는 ‘인지적 오프로딩(cognitive offloading)’ 지적

中 푸단대 등 학부 논문 AI 사용 규제 확산 추세

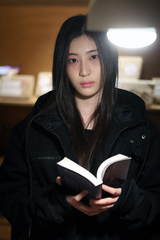

![[서울=뉴시스] 중국 대학 중 처음으로 지난해 11월 학부생 논문 작성시 인공지능(AI) 사용 규제 방안을 도입한 상하이 푸단대의 정문 모습.(출처: 바이두) 2025.01.17. *재판매 및 DB 금지](https://img1.newsis.com/2025/01/17/NISI20250117_0001752475_web.jpg?rnd=20250117103130)

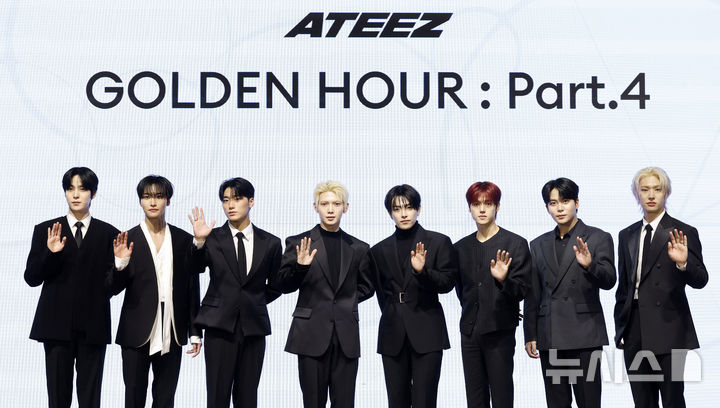

[서울=뉴시스] 중국 대학 중 처음으로 지난해 11월 학부생 논문 작성시 인공지능(AI) 사용 규제 방안을 도입한 상하이 푸단대의 정문 모습.(출처: 바이두) 2025.01.17.

*재판매 및 DB 금지

[서울=뉴시스] 구자룡 기자 = 중국을 포함 전세계 대학생들의 인공지능(AI) 사용이 늘고 있는 가운데 AI 도구를 자주 사용하면 비판적 사고 능력이 손상될 수 있다는 연구결과가 나왔다.

3일 학술 잡지 ‘소사이어티즈(Societies)’에 발표된 영국 연구팀의 조사에 따르면 17세 이상 650명 이상의 응답을 분석한 결과 AI를 광범위하게 사용하는 젊은이들의 비판적 사고 능력이 상대적으로 낮은 것으로 나타났다고 홍콩 사우스차이나모닝포스트(SCMP)가 16일 보도했다.

연구 저자인 SBS 스위스 비즈니스스쿨의 마이클 거리히는 “AI 도구에 대한 의존도가 높은 젊은 참가자들은 나이 많은 참가자들보다 비판적 사고 능력이 낮은 점수를 받았다”고 밝혔다.

그는 “이러한 연구는 AI 도구가 제공하는 편의성 때문에 인지 능력이 희생하지 않도록 해야 한다는 것을 보여준다”고 말했다.

응답자들은 다양한 소셜미디어 플랫폼을 통해 영국에서 온라인으로 모집되었으며 AI 도구 사용 빈도와 기술에 얼마나 의존하는지를 물었다.

설문지는 응답자가 기억과 문제 해결 작업을 AI에 얼마나 맡기는 지와 비판적 사고 능력을 평가하기 위해 고안되었다.

거리히에 따르면 노트, 계산기, AI와 같은 외부 도구는 정보를 관리하는 데 도움이 되지만 지나치게 의존하면 기억력과 비판적 분석 능력이 손상될 수 있다고 말했다.

연구에 따르면 17~25세의 참여자는 AI 도구 사용과 ‘인지적 오프로딩(cognitive offloading·문제해결 등의 외부 의존, 인지적 떠넘김)’이 더 높았지만 비판적 사고 지표에서는 낮은 점수를 받았다.

46세 이상의 응답자는 AI 사용과 인지적 오프로딩에서 낮은 점수를 받았지만 비판적 사고에서는 더 높은 점수를 받았다.

이 연구에서는 AI 사용과 관계없이 교육 수준이 높을수록 비판적 사고 능력이 향상된다는 사실도 발견했다. 이는 교육이 기술의 잠재적인 부정적 영향을 완화할 수 있음을 보여준다고 거리히는 말했다.

연구팀이 인터뷰한 50명의 참여자 중 일부는 AI가 권장하는 사항의 투명성과 편향성에 대한 우려를 제기했다.

한 응답자는 “AI 권장 사항의 편향에 대해 거의 생각하지 않고 전적으로 신뢰하는 경향이 있다”고 말했다.

또 다른 젊은 응답자 중 일부는 “더 깊은 인지 과정에 참여하기보다는 정보를 기억하고, 문제를 해결하고, 결정을 내리기 위해 AI에 의존하는 경우가 많다”고 말했다.

반면 한 응답자는 “AI 도구 사용으로 시간은 절약되지만 예전처럼 철저하게 생각하는 능력을 잃어가는 건 아닌지 걱정된다”고 말했다.

중국 상하이의 푸단대는 지난해 11월 중국에서는 처음으로 학부 논문에서 AI 도구 사용에 대한 규제 방안을 도입했다.

이후 베이징사범대, 화동사범대, 중국전매(미디어)대, 톈진과학기술대도 AI 사용에 대한 규정을 발표했다.

영국, 캐나다, 독일, 일본, 싱가포르, 미국의 주요 교육기관을 포함한 다른 국가의 대학들도 진화하는 AI 기술과 교육 및 학습의 성실성간의 균형을 이루는 규칙을 개발하기 위해 경쟁하고 있다고 SCMP는 전했다.

복단대 학술사무처 관계자는 신화통신 인터뷰에서 “교육자는 학생들이 AI 도구의 기능과 한계를 이해하도록 도와야 한다”며 “AI 도구는 지원 도구로만 사용하도록 해야 한다”고 말했다.

지난해 9월 발표된 별도의 연구에 따르면 스웨덴 연구팀은 학술 검색 엔진인 ‘구글 스칼라(Google Scholar)’에서 컴퓨팅, 환경, 건강 및 기타 연구 분야의 의심스러운 논문 139편을 찾아냈다.

스웨덴 연구팀은 논문에 챗GPT에서 사용하는 일반적인 응답이 포함되어 있는 것을 밝혀냈다.

대표적인 것 중에는 “내가 마지막으로 알고 있는 내용에 따르면”이나 “실시간 데이터에 접근할 수 없다” 는 등의 표현이다.

이 같은 표현이 들어간 논문의 일부는 주류 과학 저널과 학회 회의록에도 게재됐다.

연구팀은 “연구 인프라의 모든 영역에 스며드는 ‘조작된 연구’의 양은 학술 커뮤니케이션 시스템을 압도하고 과학 기록의 무결성을 위협한다”고 경고했다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지