대세는 AI…삼성전자, 차세대 고성능 메모리 대거 공개

올해 처음 열린 '멤콘(MemCon) 2023' 참가

한진만·최진혁 부사장 메모리 미래 비전 밝혀

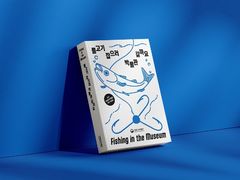

![[서울=뉴시스]한진만 미주총괄(DSA) 부사장이 28일(현지시간) 열린 'MemCon 2023'에서 개회사를 하고 있다. (사진=삼성전자 제공) photo@newsis.com *재판매 및 DB 금지](https://img1.newsis.com/2023/03/29/NISI20230329_0001229020_web.jpg?rnd=20230329141418)

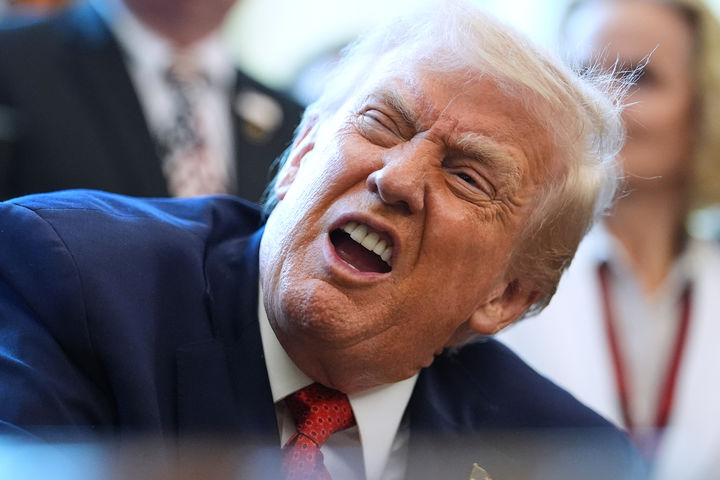

[서울=뉴시스]한진만 미주총괄(DSA) 부사장이 28일(현지시간) 열린 'MemCon 2023'에서 개회사를 하고 있다. (사진=삼성전자 제공) [email protected] *재판매 및 DB 금지

[서울=뉴시스]이인준 기자 = 삼성전자는 인공지능(AI) 메모리 솔루션 학회에서 차세대 고성능 메모리 솔루션을 대거 공개했다.

삼성전자는 28일(현지 시각) 미국 캘리포니아 마운틴뷰에서 열린 '멤콘(MemCon) 2023'에 참석했다고 밝혔다. 멤콘은 AI 관련 메모리 솔루션을 보다 심층적으로 다루기 위해 올해 처음으로 개최되는 학회다. 글로벌 IT 기업들을 중심으로 메모리, 디바이스 및 서버 업계를 이끄는 다양한 업체들이 참여했다.

삼성전자 반도체는 초거대 AI 모델을 지원하는 HBM-PIM(고대역폭 프로세싱인 메모리), CXL(컴퓨트 익스프레스 링크) 기반 PNM(프로세스 니어 메모리), SmartSSD(스마트스테이트솔리드드라이브), Memory-Semantic SSD(메모리 시멘틱 SSD), Memory Expander(메모리 익스텐더) 등 다양한 메모리 제품들도 공개했다.

HBM-PIM와 CXL-PNM은 AI 응용처에 적용했을 때 기존 솔루션 대비 GPU 가속기의 성능을 획기적으로 향상시킬 수 있는 제품이다.

예를 들어 챗GPT와 같은 AI 챗봇에 사용되는 GPT-3 언어 모델의 경우 전체 연산 기능 가운데 PIM을 적용해 가속할 수 있는 부분이 80% 이상으로 예측된다. HBM-PIM을 적용하면, HBM만 사용했을 때보다 AI 모델의 성능이 약 3.4배 이상 향상된다.

또 CXL 기반 PNM 솔루션은 메모리 용량 추가가 용이한 CXL 인터페이스를 활용해, 메모리 용량을 기존 GPU 가속기 대비 4배로 늘릴 수 있다. 또 데이터 이동을 줄여 AI 모델의 로딩 속도도 2배 이상 빨라지는 효과도 있다.

차세대 저장장치인 '2세대 SmartSSD'도 이번 학회에 공개돼 주목을 받았다. 이 제품은 1세대 대비 크게 향상된 성능을 바탕으로 데이터 연산처리 시간과 에너지 소모량을 줄일 수 있다.

또 Memory-Semantic SSD는 일반 SSD 대비 20배에 달하는 임의 읽기 속도와 응답속도를 제공한다. 데이터센터 AI와 머신러닝에 적합한 제품이다.

이번 행사에서 미주총괄(DSA) 한진만 부사장은 개회사를 맡아 메모리 기술 혁신의 필요성을 강조했다. 이어 미주 메모리연구소장(DSRA-Memory) 최진혁 부사장이 '데이터 중심 컴퓨팅 시대의 메모리 혁신'을 주제로 삼성전자 반도체 메모리 기술의 비전을 제시했다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지