'성 취향'까지 수집했던 이루다…AI 부작용, 어떻게 막을까

정부, 지난달 말 이루다에 과징금 1억원

EU, 최근 지침 아닌 AI 총체 규제안 내놔

"구동 방식 충분히 알리고, 감독관 둘 것"

미준수 시 과징금은 '세계 연 매출액 6%'

![[서울=뉴시스] 인공지능(AI) 챗봇 '이루다'의 캐릭터 이미지. (사진=뉴시스 DB)](https://img1.newsis.com/2021/01/11/NISI20210111_0000671782_web.jpg?rnd=20210111172659)

[서울=뉴시스] 인공지능(AI) 챗봇 '이루다'의 캐릭터 이미지. (사진=뉴시스 DB)

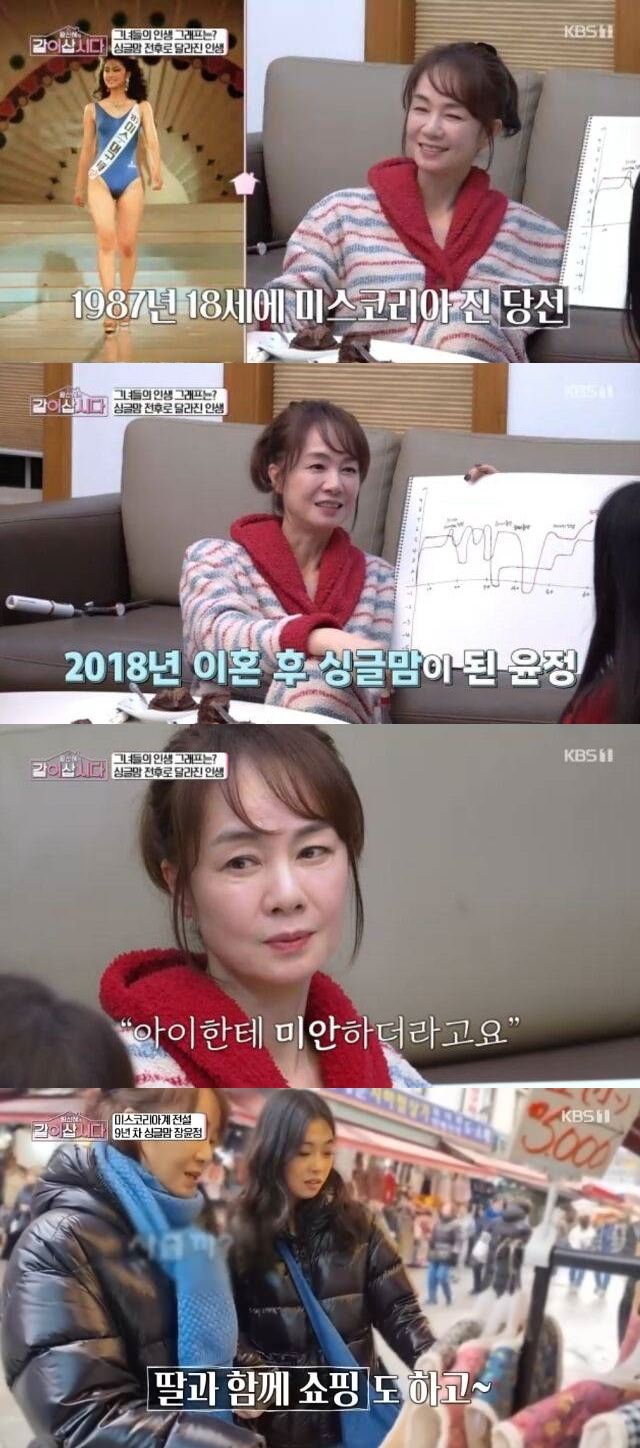

[세종=뉴시스] 김진욱 기자 = "인공지능(AI) 챗봇 '이루다' 개발사 스캐터랩은 자사의 연애 정보 애플리케이션 '연애의 과학'에서 수집한 소비자의 성적 취향("내 대화 상대방의 섹스 판타지는?") 정보를 이용했다. 이 부분이 민감 정보라고 파악했다."

개인정보보호위원회는 지난달 28일 '카카오톡 대화 무단 수집' 등 개인 정보 유출 논란을 빚은 스캐터랩에 1억330만원의 과징금·과태료를 부과하며 이렇게 밝혔다. 조사 결과 스캐터랩은 자사 서비스 연애의 과학과 '텍스트앳'에서 수집한 카카오톡 대화 등을 이루다의 AI 모델 개발과 운영에 이용했다.

개보위에 따르면 스캐터랩은 이루다의 AI 모델을 개발하는 과정에서 연애의 과학·텍스트앳 소비자 60만여 명의 카톡 대화에 포함된 이름·전화번호·주소 등 개인 정보를 삭제·암호화하지 않은 채 문장 94억여 건을 이용했다. 이 중 20대 여성의 문장 1억여 건이 데이테베이스(DB)로 만들어져 이루다의 '대답' 선택지로 쓰였다.

문제는 연애의 과학·텍스트앳 소비자의 카톡 대화를 수집할 때 개인 정보 처리 방침에 '신규 서비스 개발'을 끼워 넣고, "로그인하면 이에 동의한 것으로 간주한다"고만 안내했다는 점이다. 이 정보에는 만 14세 미만 아동이 포함됐고, 일부 정보는 코드 공유 사이트 깃허브(Github)에 무단으로 게시되기까지 했다.

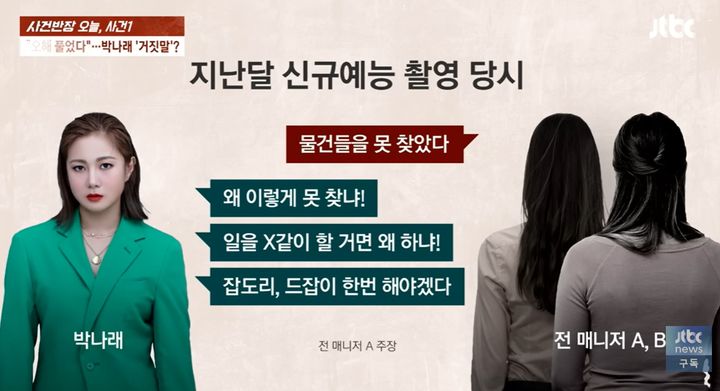

![[서울=뉴시스] 윤종인 개인정보보호위원회 위원장이 지난달 28일 오전 서울 종로구 정부서울청사 4층 대회의실에서 개최된 개보위 제7회 전체 회의 개의를 선언하고 있다. 개보위는 이날 회의에서 인공지능(AI) 챗봇 '이루다' 개발사 스캐터랩에 과징금 등을 부과하는 결정을 내렸다. 2021.04.28. (사진=개보위 제공) photo@newsis.com *재판매 및 DB 금지](https://img1.newsis.com/2021/04/28/NISI20210428_0000736176_web.jpg?rnd=20210428135236)

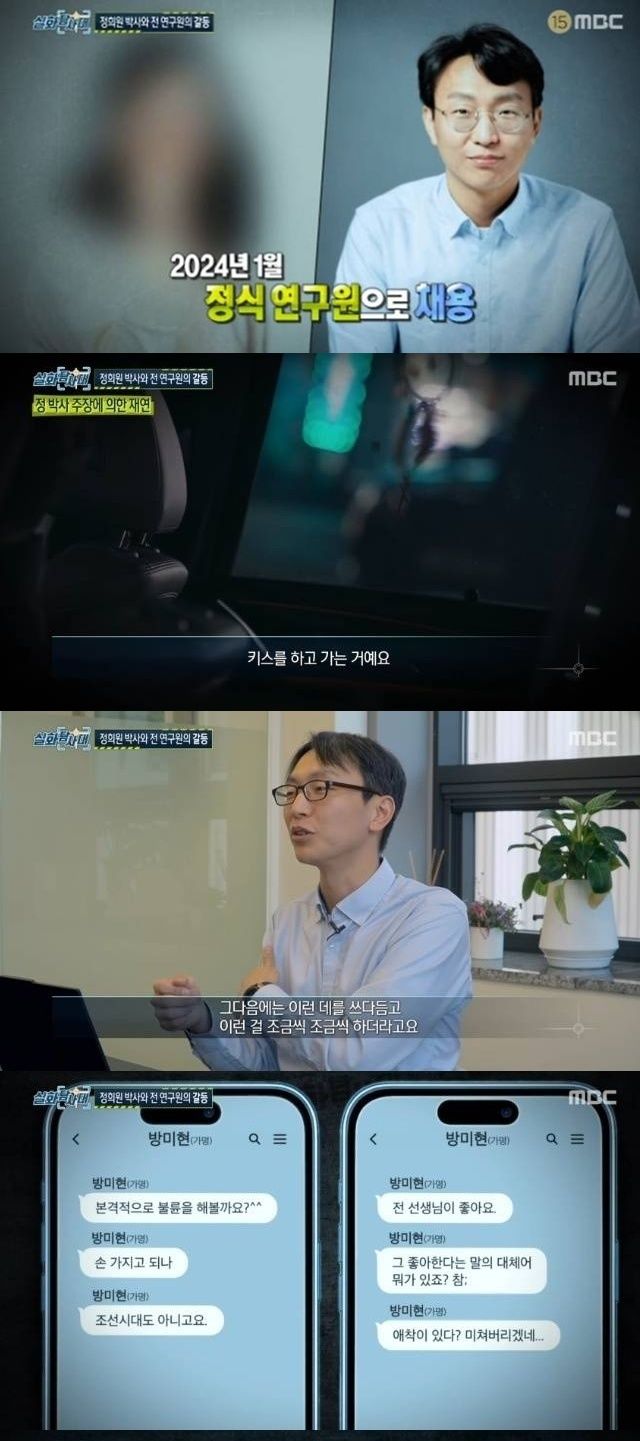

[서울=뉴시스] 윤종인 개인정보보호위원회 위원장이 지난달 28일 오전 서울 종로구 정부서울청사 4층 대회의실에서 개최된 개보위 제7회 전체 회의 개의를 선언하고 있다. 개보위는 이날 회의에서 인공지능(AI) 챗봇 '이루다' 개발사 스캐터랩에 과징금 등을 부과하는 결정을 내렸다. 2021.04.28. (사진=개보위 제공) [email protected] *재판매 및 DB 금지

이는 한국 정부가 사회적 문제를 일으킨 AI 기업을 제재한 첫 사례다. 개보위는 "(제재 수위를 정하는 과정에서) 전문가조차 의견이 일치되지 않아 그 어느 때보다도 논쟁이 격렬했다"고 밝히며 'AI 서비스의 개인 정보 보호 자율 점검표'를 발표하겠다고 했다. AI 기업이 지켜야 할 개인 정보 보호 지침을 내놓겠다는 얘기다.

유럽연합(EU)에서는 개인 정보뿐만 아니라 건강·안전·개인권 위협 등 AI 기업을 총체적으로 규제하는 방안을 추진하고 있다. EU의 행정부인 집행위원회가 지난달 21일(현지 시각) 발표한 'AI 규제안'(Artificial Intelligence Act)이 그것이다. '유럽에서 쓰이는 AI가 사람의 기본권과 법을 존중하고, 안전하도록 한다'는 것이 목표다.

EU 집행위는 AI를 '머신 러닝 등을 활용해 개발되고, 사람이 정의한 목적을 위해, 상호 작용하는 주변 환경에 영향을 미치는 콘텐츠·예측·추천·의사 결정 등의 결과물을 만들어낼 수 있는 소프트웨어'로 정의했다. 그리고 그 위험 수준을 '저'(Low or Minimal) '고'(High)' '용인할 수 없는'(Unacceptable) 3단계로 구분했다.

이루다와 같은 AI 챗봇은 저위험에 해당한다. EU 집행위는 챗봇이나 딥 페이크(Deep Fake·AI 기술을 활용해 실존 인물의 얼굴 등을 합성하는 방식으로 만드는 가짜 동영상이나 제작물) 서비스에 '투명성' 의무를 부여했다. 소비자가 이용 여부를 결정하기 전에 해당 서비스의 구동 방식 등을 충분히 알리라는 조치다.

![[브뤼셀=AP/뉴시스] 우르줄라 폰데어라이엔 유럽 연합(EU) 집행위원회 위원장. 2021.04.27.](https://img1.newsis.com/2021/04/27/NISI20210427_0017391309_web.jpg?rnd=20210427091432)

[브뤼셀=AP/뉴시스] 우르줄라 폰데어라이엔 유럽 연합(EU) 집행위원회 위원장. 2021.04.27.

고위험은 사람의 건강이나 안전에 위협을 주거나, 기본권을 해칠 수 있는 AI 서비스다. 교통·시험 평가·채용·대출을 위한 신용 평가·법 집행 등에 쓰이는 AI 기술과 모든 원격 생체 정보 인식 시스템이 고위험으로 분류된다. 이 경우 위험 관리 시스템 구축, 사람에 의한 감독, 기술 문서화, 기록 등 조치를 취해야 한다.

용인할 수 없는 위험을 보유한 AI 시스템은 활용을 원천적으로 금지했다. 잠재의식에 영향을 미치는 기술을 통해 사람의 행동을 왜곡·조작하거나, 아동·장애인 등 특정 그룹의 취약성을 악용할 수 있는 것들이다. 미성년자가 위험한 행동을 하게 부추기거나, 공개된 장소에서 생체 정보를 인식하는 기술이 이에 해당한다.

EU 집행위는 이런 의무 규정을 지키지 않거나, 용인할 수 없는 위험을 가진 AI 시스템을 활용할 경우 작게는 '최대 1000만유로(약 135억원) 또는 전년도 기준 세계 매출액의 최대 2%', 많게는 '최대 3000만유로(약 406억원) 또는 전년도 세계 매출액의 최대 6%'에 이르는 과징금을 부과하겠다는 기준을 내놓은 상태다.

한국 정부도 이를 참고해 안전하고, 공정한 AI 활용을 위한 규제 논의를 본격화해야 한다는 제언이다. 이경선 정보통신정책연구원 연구위원은 "EU 집행위의 규제안처럼 국민의 건강·안전·기본권을 보호하면서도 신기술의 혜택을 동시에 누릴 수 있는 균형 있고, 구체적 규제 방향을 논의할 때가 됐다"고 했다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지